Was sind ETL-Prozesse? - Definition, Vorteile & Einsatzzwecke

Hast Du dich jemals gefragt, wie große Unternehmen es schaffen, Berge von Daten aus unterschiedlichen Quellen zusammenzuführen, zu bereinigen und dann für wichtige Entscheidungen zu nutzen? Es ist kein Hexenwerk, sondern eine sorgfältige Methode, die das Rückgrat jeder modernen Datenanalyse bildet.

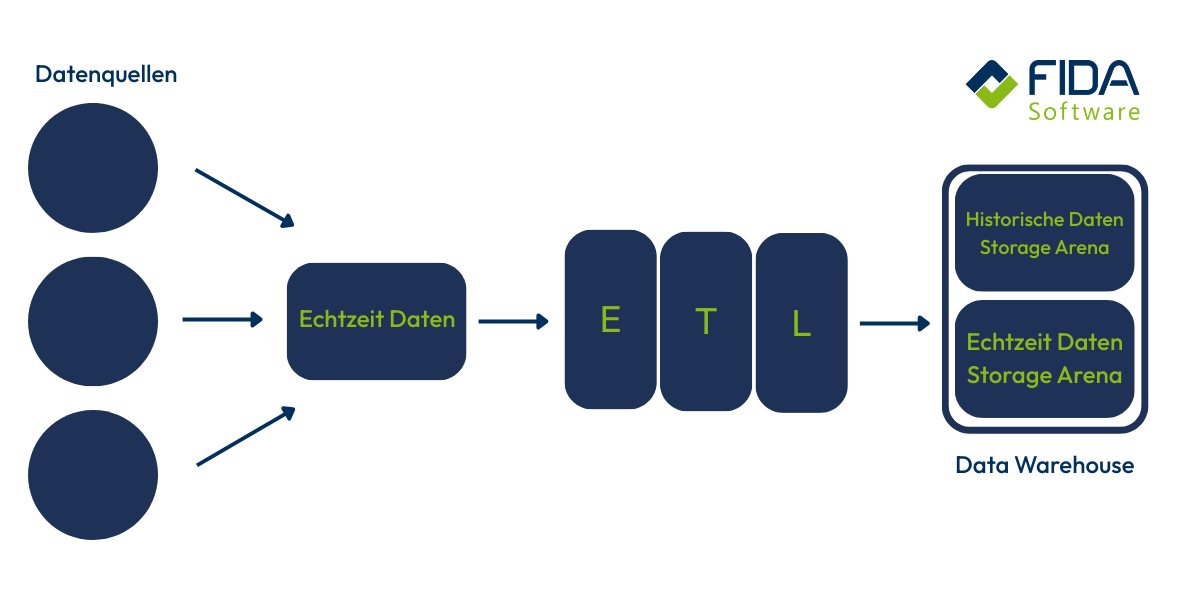

In der heutigen digitalen Welt sind Daten Dein wichtigstes Kapital. Aber Daten, die unstrukturiert in verschiedenen Systemen schlummern, sind wie Rohdiamanten – wertvoll, aber nutzlos, bis sie geschliffen sind. Genau hier kommt der ETL-Prozess ins Spiel. Die vollständige Bezeichnung von ETL ist 'Extract, Transform, Load' und beschreibt die drei zentralen Schritte, mit denen Rohdaten für Data Warehouses, Data Lakes oder Business-Intelligence-Analysen vorbereitet werden.

Extract, Transform, Load – diese drei Schritte sind der Schlüssel, um Deine Rohdaten in aussagekräftige Informationen zu verwandeln. Der Begriff 'ETL' wird häufig im Zusammenhang mit Datenintegration und Datenmigration verwendet und unterscheidet sich von anderen Begriffen wie ELT (Extract, Load, Transform) und DWH (Data Warehouse), die jeweils eigene Schwerpunkte und Anwendungsbereiche haben. Wir wollen Dir in diesem Beitrag zeigen, was ETL wirklich bedeutet, warum es für Dein Unternehmen unverzichtbar ist und wie wir gemeinsam Deine Datenprojekte optimieren können.

Definition: Was ist der ETL-Prozess?

ETL ist die technische Methode aus der Informatik, um Daten effizient aus heterogenen Quellen zu integrieren, zu standardisieren und in einem zentralen Zielsystem für die Analyse bereitzustellen. Es ist Dein Werkzeug, um die Komplexität der Datenlandschaft zu beherrschen. Die Nutzung eines ETL-Prozesses ist notwendig, weil unternehmensrelevante Daten aus unterschiedlichen internen sowie externen Quellen stammen.

Wenn wir über das Management und die Analyse großer Datenmengen sprechen, begegnest Du unweigerlich dem ETL Prozess. Dieser Prozess bildet das Fundament für jedes Data Warehouse und jede BI-Lösung. Der ETL-Prozess besteht aus mehreren klar definierten Einzelschritten, die nacheinander ablaufen und die Datenaufbereitung strukturieren.

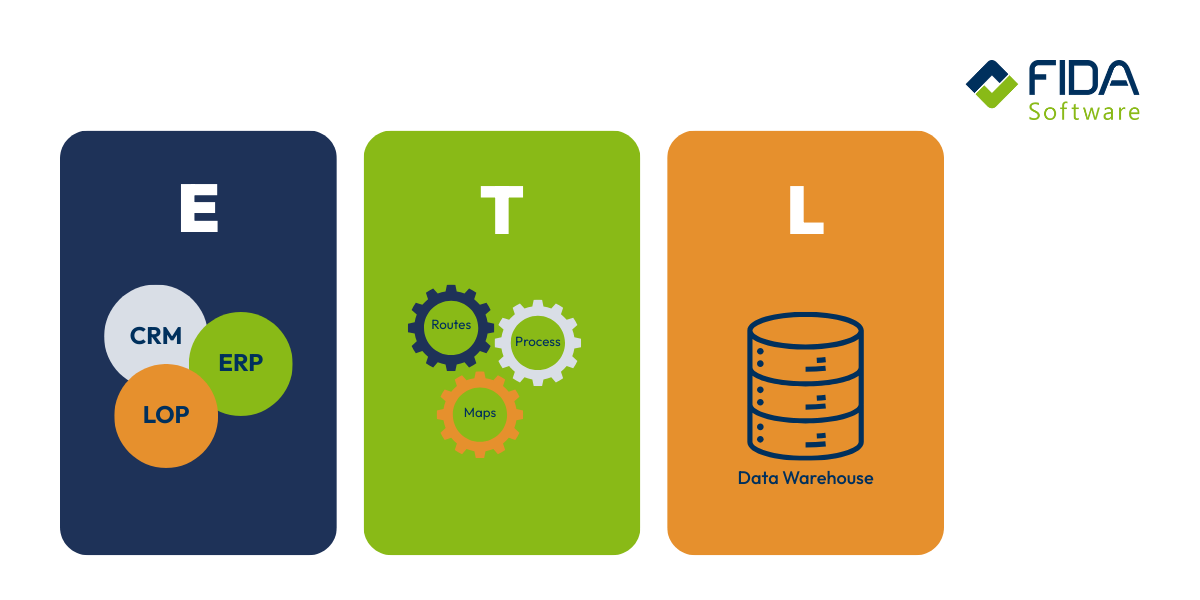

Deine unternehmensrelevanten Daten stammen häufig aus unterschiedlichsten internen (z. B. ERP, CRM) und externen Quellen (z. B. Marktdaten, Social Media). Um diese Daten als Informationen nutzbar zu machen, sind die folgenden drei aufeinanderfolgende Schritte notwendig:

Extract / Extraktion (Datenbeschaffung): In dieser Phase werden die Rohdaten aus den verschiedenen Quellsystemen extrahiert.

Transform / Transformation (Datenveredelung): Dies ist der entscheidende Schritt, in dem die extrahierten Daten transformiert werden. Die Datentransformation umfasst die Vereinheitlichung, Konvertierung und Bereinigung der Rohdaten.

Load / Laden (Datenbereitstellung): Im letzten Schritt werden die vollständig aufbereiteten und strukturierten Daten in das zentrale Zielsystem – üblicherweise das Data Warehouse – übertragen und dort für Deine analytischen Anwendungen zugänglich gemacht.

Diese drei Schritte gewährleisten, dass Du stets eine konsistente, qualitativ hochwertige und vollständige Datenbasis für Deine Analysen zur Verfügung hast. ETL-Prozesse sorgen dafür, dass konsistente und bereinigte Daten in Dein Data Warehouse gelangen.

Warum lohnen sich ETL Prozesse?

Warum solltest Du den Aufwand betreiben, einen strukturierten ETL-Prozess zu implementieren? Ganz einfach: ETL-Prozesse werden in verschiedenen Branchen und Unternehmensbereichen eingesetzt, um Daten aus unterschiedlichen Bereichen zu organisieren und Prozesse zu optimieren. Sie helfen Organisationen jeder Größe, Ressourcen effizienter zu nutzen und ermöglichen eine reibungslose Migration von Daten zwischen Systemen. Sie liefern Dir die notwendige Grundlage, um datengesteuerte Entscheidungen schnell und sicher treffen zu können.

Hier sind einige der zentralen Vorteile, die Du dadurch gewinnst:

Höhere Datenqualität und -konsistenz: Durch die obligatorische Transformationsphase bereinigst Du fehlerhafte oder inkonsistente Daten bereits vor dem Laden. Das bedeutet, dass die Daten, die Du analysierst, immer verlässlich und vereinheitlicht sind. Du kannst dich auf die Ergebnisse verlassen.

Fundierte Entscheidungen: Erst die zentrale Zusammenführung aller relevanten Informationen in Deinem Data Warehouse ermöglicht Dir eine ganzheitliche Sicht auf Dein Geschäft. Du siehst Zusammenhänge, erkennst Trends und triffst Entscheidungen nicht aus dem Bauch heraus, sondern datenbasiert.

Zeitersparnis bei der Analyse: Da die Daten bereits im Zielsystem optimiert und strukturiert vorliegen, entfällt für Deine Analytiker und Fachentscheider die aufwendige manuelle Aufbereitung. Sie können sofort mit der eigentlichen Analyse beginnen und sich auf die Wertschöpfung konzentrieren.

Compliance und Audit-Fähigkeit: Der ETL-Prozess erstellt eine klare Historie, wie Daten von der Quelle ins Zielsystem gelangt sind. Dies sorgt für eine hohe Nachvollziehbarkeit (Data Lineage) und hilft Dir, gesetzliche Anforderungen und interne Richtlinien zur Datenverwaltung leichter einzuhalten.

Effiziente Systemauslastung: Die Extraktion und Transformation findet außerhalb der operativen Quellsysteme statt. Dadurch vermeidest Du Leistungseinbußen in Deinen kritischen Geschäftsanwendungen, während die Daten für die Analyse aufbereitet werden.

Komplexität und Fehleranfälligkeit der Abfragen: Wenn Deine aktuellen Methoden, Daten abzufragen und zusammenzuführen, zu ineffizient, fehleranfällig oder gar unmöglich sind, bietet Dir ETL die notwendige Struktur.

Zentralisierung der Analyse: Du möchtest eine zentrale Instanz für alle Deine Datenanalysen schaffen – Dein Data Warehouse. ETL stellt sicher, dass alle Daten vereinheitlicht und dorthin transportiert werden.

Big Data und heterogene Formate: Auch bei der Erschließung und Auswertung von sehr umfangreichen Datenmengen (Big Data) aus unterschiedlichsten Formaten ist der ETL-Ansatz relevant, da er die notwendige Standardisierung leistet.

Unternehmensgröße ist keine Grenze: ETL ist nicht nur etwas für Großkonzerne. Auch für kleine und mittlere Unternehmen (KMU), deren Datenvolumen und Marktanforderungen wachsen, ist dieser strukturierte Ansatz von großer Bedeutung.

Darüber hinaus verwendest Du ETL-Prozesse auch für technische Aufgaben wie die Datenmigration zwischen verschiedenen Anwendungen oder zur Datenreplikation für Sicherungs- und Archivierungszwecke.

Die drei Kernverfahren im Detail: E, T und L

Um die Komplexität Deines Datenmanagements zu beherrschen, ist ein tiefes Verständnis der drei Phasen des ETL-Prozesses unerlässlich.

Schritt 1: Extract / Extraktion (Das Gewinnen der Quelldaten)

Die Extraktion ist die initiale Phase, in der Du die Rohdaten aus den verschiedensten operativen Quellsystemen (wie ERP, CRM, Datenbanken, Sensordaten) ziehst. Die größte Herausforderung liegt hier in der Heterogenität der Datenquellen, da sie unterschiedliche Formate, Technologien und Datenmodelle verwenden. Moderne Datenservices ermöglichen es, Daten in Echtzeit zu extrahieren und bereitzustellen, was für aktuelle ETL-Prozesse und Datenintegrationslösungen essenziell ist. Cloud-Plattformen wie AWS bieten dabei leistungsfähige Services für die Datenextraktion, -transformation und -ladung, insbesondere bei der Integration in Data Warehouse-Umgebungen.

Du musst entscheiden, welche Extraktionsstrategie am besten zu Deinen Systemen und Anforderungen passt:

Vollständige Extraktion (Statisch): Bei der ersten Befüllung Deines Data Warehouse oder bei der Wiederherstellung eines Systems ist die vollständige Extraktion notwendig. Sie erzeugt ein umfassendes Abbild der Quelle, ist aber ressourcenintensiv und zeitaufwendig.

Delta-Extraktion (Inkrementell): Für den laufenden Betrieb ist die Delta-Extraktion effizienter. Du liest nur die Datensätze, die sich seit dem letzten Lauf geändert haben. Dies geschieht oft über Zeitstempel-Felder oder Transaktionsprotokolle (Change Data Capture) der Quellsysteme.

Übertragungsart: Du musst auch festlegen, ob die Extraktion synchron (sofortige Verarbeitung, hohe Netzwerkauslastung) oder asynchron (zeitversetzte Verarbeitung, ressourcenschonender) erfolgt. Die Extraktion kann synchron oder asynchron erfolgen, wobei die synchrone Extraktion die Datenbestände kontinuierlich aktualisiert. Die Wahl beeinflusst direkt, wie aktuell Deine Analysen sein werden.

Das Ergebnis dieser Phase sind die Rohdaten im sogenannten Staging-Bereich, einem Zwischenspeicher, der als Basis für die Transformation dient. Eine effiziente Datenspeicherung im Staging-Bereich und in Cloud-Umgebungen ist entscheidend, um eine solide Grundlage für die weitere Datenverarbeitung und -analyse zu schaffen.

Schritt 2: Transform / Transformation (Die Veredelung und Bereinigung)

Die Transformationsphase ist qualitätsentscheidend. Ihre Aufgabe ist es, die heterogenen Rohdaten in das einheitliche Format und die konsistente Struktur zu bringen, die Dein Data Warehouse benötigt. Dabei bringt der Transformationsprozess die extrahierten Daten in ein einheitliches, unternehmensintern verwertbares Format. Ohne diesen Schritt würdest Du Auswertungen auf fehlerhaften oder widersprüchlichen Informationen aufbauen.

Im Transformationsschritt führst Du mehrere kritische Aufgaben durch, die zusammenfassend als Data Cleansing bezeichnet werden:

Bereinigung (Cleaning): Du identifizierst und korrigierst Datenfehler (z. B. Tippfehler, fehlende Werte, ungültige Formate). Du musst entscheiden, ob Du fehlerhafte Datensätze löschst, korrigierst oder die fehlenden Werte ergänzt.

Standardisierung und Normalisierung: Du stellst sicher, dass Datenfelder (z. B. Adressen, Datumswerte) über alle Quellen hinweg einheitlich dargestellt werden, um eine semantische Konsistenz zu gewährleisten.

Aggregation und Derivation: Du fasst Daten zusammen (z. B. Monatsumsatz statt Einzeltransaktionen) oder leitest neue Metriken ab, die für Deine Analysen wichtig sind, aber in den Quellsystemen nicht existieren.

Verknüpfung und Anreicherung: Du führst Daten aus verschiedenen Quellen zusammen (z. B. Kunden-ID aus dem CRM mit Auftragsdaten aus dem ERP) und reicherst Datensätze mit zusätzlichen, relevanten Informationen an.

Data Profiling: Data Profiling wird als automatisierte Methode eingesetzt, um die Datenqualität während des Transformationsprozesses zu analysieren und zu bewerten.

Ziel ist es, Anomalien (fehlerhafte oder redundante Datensätze) zu eliminieren, damit Du am Ende verlässliche Informationen für Deine Berichte hast.

Schritt 3: Load / Laden (Die finale Bereitstellung)

Im letzten Schritt überträgst Du die nun vollständig bereinigten und strukturierten Daten aus dem Staging-Bereich in Dein Zielsystem, meist das Data Warehouse (DWH) oder einen Operational Data Store (ODS).

Auch hier gibt es verschiedene Strategien, je nach Anforderung an die Aktualität und die Systemverfügbarkeit:

Initial Load: Das erstmalige Beladen des DWH mit dem kompletten Datenbestand.

Incremental Load: Das regelmäßige Hinzufügen oder Aktualisieren der Delta-Daten, die in der Extraktionsphase ermittelt wurden.

Überprüfung und Integrität: Während des Ladevorgangs müssen Integritätsprüfungen stattfinden, um sicherzustellen, dass die Daten korrekt in die Zieltabelle eingefügt werden.

Besonders bei großen Datenmengen können Sperrzeiten notwendig sein. Diese verhindern, dass Analysten oder BI-Systeme auf die Daten zugreifen, solange der Ladevorgang noch läuft, und stellen so die Datenintegrität sicher. Nur wenn der Prozess erfolgreich abgeschlossen ist, kannst du gewährleisten, dass alle Abfragen auf dem aktuellsten und konsistentesten Stand der Informationen basieren.

Du suchst Unterstützung bei der Implementierung oder Optimierung eines ETL Prozesses? Dann kontaktiere uns!

Welche Anforderungen stellt ein ETL-Prozess an Deine Infrastruktur?

Die erfolgreiche Implementierung und der Betrieb eines ETL-Prozesses stellen klare Anforderungen an Deine IT-Infrastruktur. Du benötigst leistungsfähige Komponenten, welche sicherstellen, dass die Datenverarbeitung schnell und zuverlässig abläuft.

Hier sind die zentralen Infrastrukturkomponenten, die Du bereitstellen musst:

Der ETL-Server (Verarbeitungsinstanz): Die Transformation ist rechenintensiv. Daher benötigst Du einen dedizierten Server oder eine virtuelle Maschine mit ausreichender CPU-Leistung und Arbeitsspeicher (RAM). Dieser Server führt die eigentlichen ETL-Tools aus und managt die komplexen Logiken zur Datenbereinigung und -strukturierung. Eine hohe Rechenleistung ist notwendig, um die Prozesse in einem akzeptablen Zeitfenster abzuschließen.

Der Staging-Bereich: Wie bereits erwähnt, benötigen die extrahierten Rohdaten einen temporären Zwischenspeicher, bevor sie transformiert werden. Dieser Staging-Bereich erfordert schnellen Speicherplatz mit hoher I/O-Performance (Input/Output), da große Datenmengen schnell gelesen und geschrieben werden müssen. Oft wird hierfür eine performante Datenbank oder ein File-Storage genutzt.

Das Zielsystem (Data Warehouse): Das Data Warehouse (DWH) oder der Operational Data Store (ODS) ist Dein finales Ziel. Dieses System muss extrem skalierbar und auf analytische Abfragen optimiert sein. Hier spielt die Datenbanktechnologie eine entscheidende Rolle, denn sie muss die großen Mengen an strukturierten Daten effizient speichern und schnelle Antwortzeiten für Deine Business Intelligence (BI)-Tools liefern.

Netzwerkkapazität: Während der Extraktions- und Ladephasen werden oft sehr große Datenmengen über das Netzwerk bewegt – von den Quellsystemen zum ETL-Server und vom ETL-Server zum DWH. Eine ausreichende Bandbreite und ein stabiles Netzwerk sind entscheidend, um Engpässe und lange Laufzeiten zu vermeiden.

Überwachung und Wartung: Du benötigst robuste Tools zur Überwachung des ETL-Prozesses. Dazu gehören Scheduling- und Logging-Funktionen, um sicherzustellen, dass die Prozesse pünktlich starten, Fehler protokolliert werden und Du bei Ausfällen schnell reagieren kannst.

Indem Du diese Anforderungen berücksichtigst und die Infrastruktur richtig dimensionierst, schaffst Du die Grundlage für einen effizienten und zuverlässigen Datenfluss in Deinem Unternehmen.

ETL vs. ELT was ist der Unterschied?

In der modernen Datenwelt ist neben dem klassischen ETL-Ansatz eine wichtige Alternative entstanden: ELT (Extract, Load, Transform). Während beim ETL-Prozess die Transformation vor dem Laden ins Zielsystem erfolgt, unterscheidet sich der ELT-Prozess dadurch, dass die Daten zunächst vollständig in das Zielsystem geladen und erst danach transformiert werden. Obwohl die gleichen Schritte involviert sind, führt die veränderte Reihenfolge zu einem grundlegend anderen Vorgehen bei der Datenintegration.

Beim klassischen ETL entziehst Du die Daten (Extract), veredelst sie auf einem separaten ETL-Server (Transform) und lädst erst dann die fertigen, bereinigten Daten in Dein Data Warehouse (Load). Hier findet die rechenintensive Transformation außerhalb des Zielsystems statt. Das ist oft sinnvoll bei älteren Datenbanktechnologien oder wenn Du nur die unbedingt notwendigen, schlanken Datensätze speichern möchtest.

Der ELT-Ansatz dreht die letzten beiden Schritte um. Hier werden die Rohdaten nach der Extraktion zuerst vollständig in das Data Warehouse geladen (Load). Die Transformation (T) findet dann innerhalb des Zielsystems statt, typischerweise unter Nutzung der hohen Rechenleistung moderner Cloud Data Warehouses (wie Snowflake oder BigQuery). Der ELT-Prozess ermöglicht dadurch eine schnellere Datenbereitstellung, da die Transformation erst nach dem Laden erfolgt.

Der große Vorteil des ELT-Ansatzes für dich liegt in der Flexibilität und der Rohdatenhaltung. Da alle Daten sofort im DWH verfügbar sind, kannst Du Transformationen jederzeit und mehrfach mit unterschiedlichen Logiken durchführen. Du sparst Dir den dedizierten ETL-Server, weil Du die Rechenpower Deines Data Warehouse nutzt. Entscheidest Du dich für ELT, ist dies meist ein Indikator dafür, dass Du mit sehr großen Datenmengen (Big Data) arbeitest und die Vorteile der Cloud-Skalierbarkeit nutzen möchtest.

Relevante Software: Tools für Deinen ETL-Prozess

Um ETL- und ELT-Prozesse effizient umzusetzen, benötigst Du die richtige Software. Die Tool-Landschaft ist vielfältig und lässt sich grob in drei Kategorien unterteilen:

Cloud-Native & Hyperscaler Tools (ELT-fokussiert)

Diese Tools sind oft eng in Cloud-Plattformen integriert und eignen sich hervorragend für den modernen ELT-Ansatz, da sie die Rechenleistung der Cloud nutzen:

Azure Data Factory (ADF): Das zentrale Integrations-Tool von Microsoft Azure. Ideal, wenn Du bereits die Azure Cloud nutzt.

Google Cloud Dataflow: Ein vollständig verwalteter Dienst von Google, der sich besonders für komplexe, Streaming- und Batch-Datenverarbeitung eignet.

AWS Glue: Der serverlose ETL-Dienst von Amazon Web Services, der automatisch Metadaten (Schemas) erkennen kann.

Traditionelle ETL-Plattformen

Diese etablierten Tools bieten sehr umfangreiche Funktionen, hohe Skalierbarkeit und sind oft in komplexen Enterprise-Umgebungen im Einsatz:

Informatica PowerCenter: Einer der Marktführer, bekannt für seine Stabilität und weitreichende Konnektivität.

IBM DataStage: Eine leistungsstarke Plattform, die sich besonders für große Datenvolumina und hohe Anforderungen an die Datenqualität eignet.

Open-Source-Lösungen

Wenn Du eine kostengünstige und flexible Alternative suchst, sind Open-Source-Tools eine gute Option, die Du selbst anpassen kannst:

Apache Nifi: Ein einfach zu bedienendes, leistungsstarkes und zuverlässiges System zur Automatisierung des Datenflusses zwischen Softwaresystemen.

Die Auswahl des richtigen Tools hängt stark von Deiner vorhandenen Infrastruktur, Deinem Budget und der Komplexität Deiner Datenintegrationsanforderungen ab.

Fazit: Dein Schlüssel zur Datenhoheit

Der ETL-Prozess ist weit mehr als nur ein technisches Akronym; er ist das Fundament, auf dem Du Deine gesamte Datenstrategie aufbaust. Ob Du dich für den klassischen ETL-Weg entscheidest oder die moderne Flexibilität von ELT bevorzugst – das Ziel bleibt dasselbe: Du verwandelst rohe, verteilte Daten in eine konsistente, qualitativ hochwertige Informationsbasis, die es Dir ermöglicht, schnellere und fundiertere Geschäftsentscheidungen zu treffen.

Die Wahl und die korrekte Implementierung des richtigen Ansatzes sind jedoch komplex und hängen von Deiner spezifischen Infrastruktur und Deinen Anforderungen ab. Genau hier stehen wir Dir zur Seite.

Als Dein Partner für Data Solutions bieten wir Dir umfassendes Know-how: Wir analysieren Deine Datenlandschaft, beraten dich bei der Wahl zwischen ETL und ELT und übernehmen die professionelle Implementierung und Optimierung Deiner ETL-Prozesse. So garantieren wir Dir einen stabilen, performanten Datenfluss, damit Du Dich voll und ganz auf die Analyse und die Steigerung Deines Geschäftserfolgs konzentrieren kannst.

Sprich uns an – gemeinsam bringen wir Ordnung und Wert in Deine Daten.

FAQ Häufig gestellte Fragen zum ETL-Prozess

Der Begriff Data Integration (Datenintegration) ist der Oberbegriff und beschreibt das gesamte Ziel, nämlich die Zusammenführung von Daten aus verschiedenen Quellen. Der ETL-Prozess (Extract, Transform, Load) ist eine der zentralen Methoden oder Techniken, um dieses Ziel zu erreichen. Data Integration kann auch andere Techniken wie Virtualisierung oder ELT umfassen.

Ein Data Warehouse ist ein zentrales Datenbanksystem, das speziell für analytische Zwecke optimiert wurde. Es speichert historische und konsolidierte Daten. Der ETL-Prozess spielt die Hauptrolle beim Aufbau und der Pflege des DWH, indem er die Rohdaten aus operativen Systemen extrahiert, bereinigt und in das DWH lädt. Das DWH ist somit das primäre Zielsystem des ETL-Prozesses.

Die Häufigkeit der Ausführung hängt von der geforderten Aktualität Deiner Daten ab:

Batch-Verarbeitung: Bei täglichen, wöchentlichen oder monatlichen Reportings läuft der Prozess in festen Zeitintervallen (Batches).

Near Real-Time: Wenn Du schnellere Informationen benötigst, erfolgt der Prozess häufiger (z. B. alle 5 Minuten) oder es wird auf den ELT-Ansatz mit Streaming-Technologien zurückgegriffen, um die Daten fast unmittelbar bereitzustellen.

Ein fehlerhafter ETL-Prozess kann schwerwiegende Folgen haben. Das Hauptproblem ist die schlechte Datenqualität in Deinem Data Warehouse. Dies führt dazu, dass Du Entscheidungen auf Basis falscher oder unvollständiger Informationen triffst. Zudem können ineffiziente Prozesse zu unnötig hohen Infrastrukturkosten führen oder Deine operativen Quellsysteme überlasten.

Data Lineage (Datenherkunft oder Datenabstammung) beschreibt den Lebenszyklus eines Datensatzes, von seiner Entstehung in der Quelle über alle Transformationsschritte bis hin zur finalen Ablage im Data Warehouse. Ein sauber dokumentierter ETL-Prozess gewährleistet die Data Lineage und macht die Herkunft Deiner Daten jederzeit nachvollziehbar – ein wichtiger Aspekt für Audits und Compliance.